Die Digitalisierung hat die medizinische Versorgung in den letzten Jahren grundlegend transformiert: Telemedizin, das E-Rezept und die elektronische Patientenakte ermöglichen heute eine unkomplizierte Kommunikation zwischen Patient*in und Leistungserbringer und entlasten die Beschäftigten. Der flächendeckende Einsatz künstlicher Intelligenz ist nun der nächste logische Schritt – kann sie doch bei der ärztlichen Diagnostik unterstützen, administrativen Tätigkeiten ausführen und Patient*innen beim Krankheitsmanagement helfen.

Das Ziel: bessere Versorgung, schnellere Diagnosen, effizientere Prozesse.

Doch all das ist nur mit Zugriff auf hochsensible Daten möglich – und genau hier liegt die Herausforderung. Denn wie lässt sich die medizinische Innovation mit den strengen Datenschutzanforderungen in Einklang bringen?

Anwendungsfälle von KI im Gesundheitswesen

Die Frage, wo und wie künstliche Intelligenz im Gesundheitswesen eingesetzt werden kann, ist heute so brisant wie nie. Deshalb hat der Wissenschaftliche Beirat (WB) der Bundesärztekammer eine Stellungnahme erarbeitet. Sie zeigt die vielfältigen Anwendungsmöglichkeiten von KI in der Medizin auf: Künstliche Intelligenz kann unter anderem in der Bildgebung, der Erkrankungsdiagnostik, der Trendanalyse und dem Krankheitsmanagement – zum Beispiel bei Diabetes oder Epilepsie – eingesetzt werden. Daneben bieten vor allem sogenannte Large Language Models vielversprechende Anwendungsmöglichkeiten.

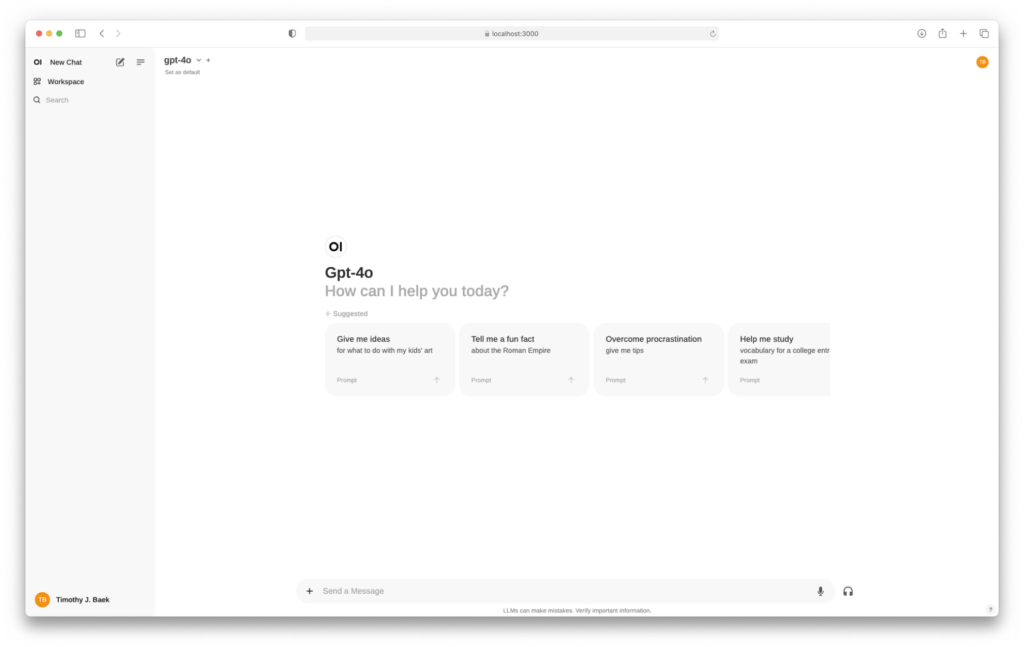

Sie sind eine Art der generativen KI, die entwickelt wurde, um textbasierte Inhalte zu generieren. Hierfür greifen Large Language Models auf Datensätze zurück, um Inhalte zu verstehen, zusammenzufassen, zu generieren und vorherzusagen. Großer Beliebtheit erfreut sich beispielsweise das Large Language Model ChatGPT. Da Systeme wie ChatGPT jedoch keine datenschutzkonforme Umgebung bieten, können sie nicht für die Verarbeitung von Patientendaten oder zu Dokumentationszwecken verwendet werden. Eine datenschutzkonforme Alternative zu Systemen wie ChatGPT stellen sichere Cloud-Umgebungen dar.

Sichere Cloud Umgebung für Ihre KI

Wir bieten Ihnen mit unserem „KI als Managed Service“-Angebot eine datenschutzsichere OpenWebUI-Instanz. BW-Tech betreibt für Sie einen geschützten KI-Cluster, der höchsten Datenschutz- und Sicherheitsanforderungen entspricht.

- Bereitstellung in unserer hochverfügbaren und sicheren Cloud-Umgebung

- Nahtlose Implementierung und eine sofortige Betriebsbereitschaft

- Umfassende Sicherheitsvorkehrungen und regelmäßige Backups

- 24/7 Überwachung Ihrer Instanz

- Regelmäßige Optimierungen und automatische Updates

Im Gesundheitswesen und insbesondere im niedergelassenen Versorgungsbereich bieten sicher betriebene Large Language Models die Möglichkeit, Informationen zu bündeln, Mitarbeitende von repetitiven Tätigkeiten zu entlasten und so mehr Raum für den Arzt-Patienten-Kontakt zu schaffen. So können Prozesse optimiert und vorhandene Ressourcen effizienter genutzt werden, um Herausforderungen im Gesundheitswesen, wie z. B. dem Fachkräftemangel, zu begegnen.

Mögliche Anwendungsfälle sind:

- Patientenaufklärung und Anamnese

- Entwerfen von Arzt-Entlassungsbriefen

- Unterstützung in der Diagnostik

- Unterstützung in der Interventionsplanung

- Dokumentation

- Dienstplanung

- Vorsorgeplanung

- Qualitätsmanagement

- Informationsrecherche

- Bewertung erhobener Daten

Funktionsweisen von LLMs

Large Language Models (LLMs) werden zunächst mit sehr großen Mengen unstrukturierter Daten trainiert und können später auf spezifische Bereiche (Medizin) oder Aufgaben (Arztbriefe verfassen) trainiert werden.

Daten von Patient*innen können dabei simultan verarbeitet werden. Die LLMs kombinieren einmal erhaltene Informationen für Diagnostik, Behandlung und Dokumentation für den jeweiligen Anwendungsfall. Damit können die KI-Modelle entlang der gesamten Kette der Patientenversorgung eingesetzt werden.

Vorsicht vor Halluzinationen

Natürlich ist die Verwendung nicht ohne Risiken: LLMs neigen zu sogenannten Halluzinationen. Hierbei handelt es sich um ein sehr überzeugend formuliertes Resultat einer KI, das eventuell falsch ist. Die KI sollte daher eher als eine Assistenz betrachtet werden. Ergebnisse müssen immer überprüft und kritisch hinterfragt werden.

All dies ist nicht möglich, ohne Daten an die generative KI weiterzugeben. Die DSGVO und das Patientendatenschutzgesetz (PDSG) setzen für die Verwendung von sensiblen Daten jedoch klare Rahmenbedingungen – etwa für Einwilligung, Zweckbindung und Datensicherheit. Die Lösung: Eine eigene KI in einer sicheren Cloud Umgebung hosten.

Sichere Cloud Umgebungen hosten - so gehen Sie vor:

1. Infrastruktur bereitstellen

Der erfolgreiche Einsatz von KI-Systemen setzt eine robuste und zuverlässige Infrastruktur voraus. Um KI-Systeme skalierbar zu betreiben, bedarf es außerdem großer Hardwareanlagen und leistungsfähiger Graphikprozessoren (GPU). Hierfür eignen sich externe Dienstleister, die sowohl Hardware als auch Grafikprozessoren in einem Mietmodell anbieten oder die KI-Instanz selbst betreiben und über eine sichere Cloud-Umgebung bereitstellen. Das spart nicht nur Anschaffungskosten, sondern garantiert auch höhere Sicherheit und Skalierbarkeit bei verändertem Bedarf.

2. OpenWeb UI nutzen

OpenWebUI ist eine flexible, leistungsstarke KI-Lösung, die es ermöglicht, eine Vielzahl von Large Language Models (LLMs) in einer sicheren, abgeschirmten Umgebung zu nutzen. Sie bietet umfassende Sicherheitsfunktionen und erfüllt strengste Compliance-Richtlinien für den Schutz sensibler Daten. Auch hier lohnt es sich, einen externen Dienstleister mit der Einrichtung zu beauftragen, falls keine internen IT-Ressourcen vorhanden sind.

KI als Managed Service

Mit unserem „KI als Managed Service“-Angebot erhalten Sie Ihre eigene Datenschutzsichere OpenWebUI-Instanz. BW-Tech betreibt für Sie einen geschützten KI-Cluster, der höchsten Datenschutz- und Sicherheitsanforderungen entspricht. Sie können Ihre eigene KI-Instanz mieten und monatlich zu einem festen Preis nutzen.

3. Auf sichere Infrastruktur und Verschlüsselung achten

Ob bei der Übertragung oder Speicherung – moderne Verschlüsselungstechnologien sorgen dafür, dass Patientendaten nicht in falsche Hände geraten. Firewalls, Zugriffsmanagement und regelmäßige Sicherheitsupdates gehören deshalb zum Pflichtprogramm. Bei der Verwendung von KI als Managed Service sollte darauf geachtet werden, dass der externe Dienstleister höchste Sicherheitsvorkehrungen trifft.

4. Datenschutz und Schweigepflicht einhalten

Bei der Weitergabe von Informationen an Personen, die bei der Anwendung des KI-Systems mitwirken, z. B. auch externe Betreiber von KI-Systemen, ist zu beachten, dass diese zur Geheimhaltung zu verpflichten sind und sich die Schweigepflicht auch auf sie erstreckt.

Für KI-Systeme die Gesundheitsdaten verwenden gilt außerdem: Patient*innen müssen in den Zweck und die Form der Verarbeitung ihrer Daten einwilligen. Dies muss gem. Art. 12 Abs. 1 i. V. m. Art. 13 oder 14 DSGVO in „verständlicher und leicht zugänglicher Form in einer klaren und einfachen Sprache“ erfolgen.

5. Transparenz und Nachvollziehbarkeit

Gerade bei Entscheidungen, die auf KI basieren, muss klar sein: Wie kam es zu diesem Ergebnis? Nachvollziehbare Algorithmen (sogenannte Explainable AI) sorgen dafür, dass medizinisches Personal und Patient*innen die Entscheidungen verstehen – und ihnen vertrauen können.

Interdisziplinäre Zusammenarbeit ist gefragt

Technologie allein reicht nicht aus. Der Schutz sensibler Gesundheitsdaten verlangt ein Zusammenspiel aus sicherer IT, Recht und Medizin. Nur wenn alle Akteure an einem Strang ziehen, lassen sich zukunftsfähige Lösungen entwickeln, die Innovation und Datenschutz vereinen. KI hat das Potenzial, das Gesundheitswesen grundlegend zu verbessern – wenn wir den Datenschutz nicht als Hindernis, sondern als integralen Bestandteil begreifen. Mit durchdachten technischen, organisatorischen und rechtlichen Maßnahmen lassen sich sensible Patientendaten schützen und gleichzeitig die Möglichkeiten von KI voll ausschöpfen.